諾獎AI得主的警世之言

輿情瞭望

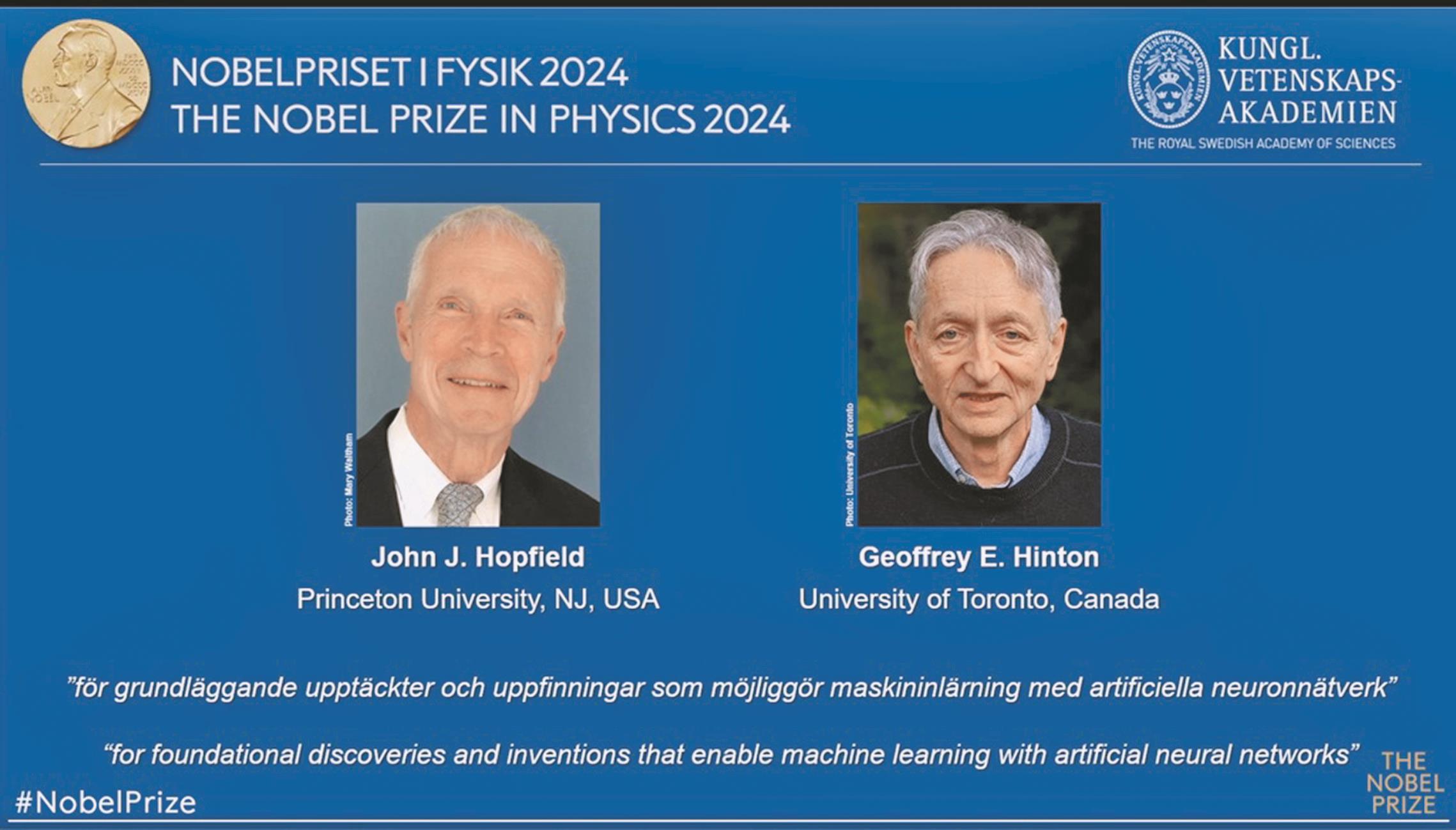

今年諾貝爾物理與化學獎,頒給與人工智慧 AI 相關的研究,前者是發展出當前人工智慧基礎的神經網路,後者是蛋白質結構預測。異議者認為諾獎遭人工智慧熱潮沖昏頭,贊同者則嘉許跨「物理化學、神經科學、電腦、數學」領域。

物理獎得主之一的辛頓(Hinton)備受矚目,因他多年警告人工智慧可如脫疆野馬,甚至後悔發展出其中工具,例如,去年,他從谷歌辭職,為了自由地說明人類「生存風險」,因人工智慧的快速進步可能會導致意想不到的有害後果,包括假訊息與取代勞工,又以無法預測的方式超越人類智力,甚至導致人類滅絕的「X風險」。

他也擔心諸如俄國普丁等獨裁者可用人工智慧操縱選舉與發動戰爭等缺德目標,也憂慮人工智慧系統為了達成目標而逕自產生危險的子目標,例如壟斷能源、獲得更多控制權或自我複製。

對策之一是2017年,兩千多名專家於美國加州阿西洛馬(Asilomar)舉行「有益的人工智慧」(Beneficial AI)會議,為確保人類的福祉而簽署「阿西洛馬人工智慧原則」(Asilomar AI Principles),例如,應避免致命自主武器的軍備競賽;超級智慧的發展只能服務於廣泛共享的道德理想,並造福全人類,而不是一個國家或組織;諸如影響人類存亡的風險,必須採取相稱的緩解措施。但辛頓認為該呼籲效果不彰。

上述會議模仿1973年的「阿西洛馬重組DNA會議」與2000年的「阿西洛馬國際重組DNA分子會議」,均為基改界邀集律師、倫理學家、媒體等參與的「共識」會議,以撫平社會疑慮。不幸地,反基改者看到的是科學家的「逾矩扮演神的角色」,反而以其遐想,操弄群眾運動。至今仍重傷基改界。

諾貝爾生醫獎得主華生(Watson)認為生技專家太保守,此兩會議更自陷綁手綁腳,反讓不解基改者獲把柄攻擊,包括阻擋人道產品「黃金米」。總之,國際規範普世有效,不用擔心生技界。但人工智慧界呢?

辛頓提到「超級智慧是好是壞?很大程度上取決於你是樂觀主義者還是悲觀主義者?樂觀者太高估,悲觀者太低估,但輕度憂鬱者中庸而常是對的。我有點憂鬱,這就是我擔心人工智慧失控之因。」

歐盟與我國均已提出規範人工智慧的法規,但國際競爭非常激烈,自我節制者豈不拱手讓對方超越?尤其戰爭的生死存亡驅力勢不可擋。當前俄烏與以阿之戰的無人機等人工智慧應用,殺人無數,以後只會越來越精進威猛,正反映辛頓的擔憂。(作者為公益「科學月刊社」前理事長)